点击蓝字

关注我们,让开发变得更有趣

作者:武卓 博士

英特尔AI软件布道师

随着人工智能技术的飞速发展,AI的应用已经渗透到日常生活的各个方面。为了更有效地利用AI技术,混合式AI部署成为了一个重要趋势。这种部署方式结合了云端和边缘计算的优势,使得AI应用更为灵活和高效。本文将探讨OpenVINO™ 如何助力混合式AI部署,实现AI的无所不在。

混合式AI部署简介

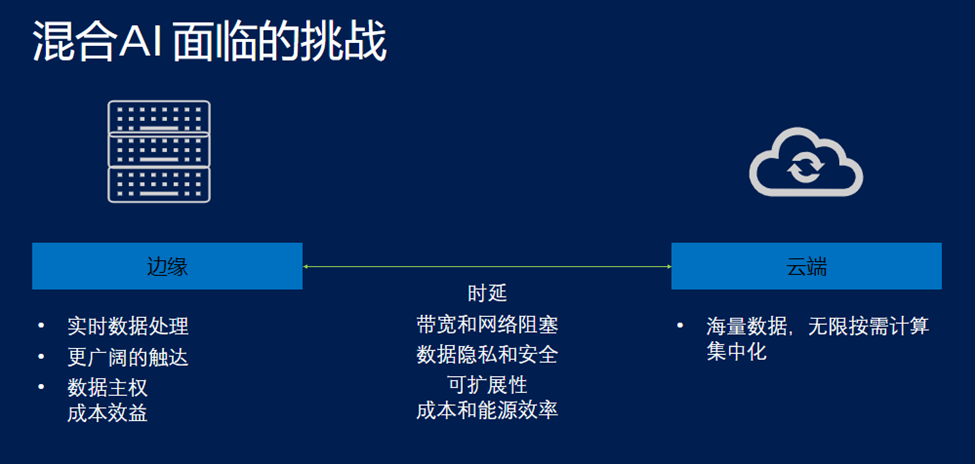

混合式AI部署是指将AI模型同时部署在云端和边缘设备上。这种方法结合了云端部署具有的海量数据强大处理能力、无限按需计算能力以及集中化处理等优点,以及边缘部署的实时数据处理能力、更广阔的场景触达、完全的数据主权以及良好的成本效益等优点。通过这种方式,可以在云端处理大规模、复杂的数据分析任务,同时在边缘设备上快速响应实时数据处理需求。

虽然混合式AI部署具有以上种种优势,但我们看到它仍然面临着时延、数据带宽、数据隐私和安全、以及可扩展成本和能源效率的种种挑战。

OpenVINO™ 平台的优势

OpenVINO™ 是英特尔开源的深度学习模型优化以及快速部署的工具套件,旨在加速深度学习模型推理工作流程。它借由模型、优化、部署三个简单的开发者旅程步骤,即可以实现深度学习模型的优化,以及“一次编写,任意部署” 。

在模型方面,OpenVINO™ 支持市面上所有主流的深度学习框架训练出来的深度学习模型,包括Tensorflow、PyTorch、Paddlepaddle等。在优化方面,OpenVINO™ 提供了模型转换器、神经网络压缩框架(NNCF)等一系列优化工具,可以对模型进行优化、量化压缩,从而可以显著减小模型体积、推理时所需的内存大小、以及提升推理速度。在部署方面,OpenVINO™ 能够方便地将模型部署在CPU、GPU、NPU以及FPGA上,实现模型的快速落地部署。

OpenVINO™ 助力混合式AI边缘部署

在边缘设备上,OpenVINO™ 的高效推理和模型快速部署能力显得尤为重要。它使得用户可以根据使用场景、AI工作负载的实际需求,灵活地选择不同的硬件设备,并完成在这些硬件设备上的快速的模型部署、以及模型推理加速,实现深度学习模型在边缘的快速落地。

结论

混合式AI部署是实现AI无所不在的重要一步。通过OpenVINO™ 的高效、灵活的特点,可以在边缘设备上,更具不同的使用场景、工作负载情况,选用不同的硬件设备,快速完成模型部署和运行模型推理,提高整体的运算效率和响应速度。随着技术的不断进步,我们期待看到更多创新的AI应用,让人工智能真正融入我们的生活。

OpenVINO™

–END–

你也许想了解(点击蓝字查看)⬇️

➡️

隆重介绍 OpenVINO™ 2024.0: 为开发者提供更强性能和扩展支持

➡️

隆重推出 OpenVINO 2023.3 ™ 最新长期支持版本

➡️

OpenVINO™ 2023.2 发布:让生成式 AI 在实际场景中更易用

➡️

开发者实战 | 基于 OpenVINO™ 和 LangChain 构建 RAG 问答系统

➡️

开发者实战 | 如何利用低比特量化技术进一步提升大模型推理性能

➡️ 开发者实战 | 介绍OpenVINO™ 2023.1:在边缘端赋能生成式AI

➡️ 基于 ChatGLM2 和 OpenVINO™ 打造中文聊天助手

➡️ 基于 Llama2 和 OpenVINO™ 打造聊天机器人

➡️ OpenVINO™ DevCon 2023重磅回归!英特尔以创新产品激发开发者无限潜能

➡️ 5周年更新 | OpenVINO™ 2023.0,让AI部署和加速更容易

➡️ OpenVINO™5周年重头戏!2023.0版本持续升级AI部署和加速性能

➡️ OpenVINO™2023.0实战 | 在 LabVIEW 中部署 YOLOv8 目标检测模型

➡️ 开发者实战系列资源包来啦!

➡️

以AI作画,祝她节日快乐;简单三步,OpenVINO™ 助你轻松体验AIGC

扫描下方二维码立即体验

OpenVINO™ 工具套件 2024.0

本文分享自微信公众号 – OpenVINO 中文社区(openvinodev)。

如有侵权,请联系 support@oschina.cn 删除。

本文参与“OSC源创计划”,欢迎正在阅读的你也加入,一起分享。